Как пользоваться нейросетью FastVLM от Apple. Она работает в браузере и может описать происходящее на видео

Apple тихо выложила в открытый доступ одну из своих самых быстрых и лёгких нейросетей — FastVLM, модель для мгновенного распознавания происходящего на видео. И самое интересное, что её уже можно попробовать прямо в браузере, без установки, на сайте Hugging Face. Главное условие, чтобы у вас был Mac с чипом Apple Silicon, иначе модель просто не запустится.

Apple продолжает демонстрировать всем возможности ИИ. Изображение: 9to5mac.com

❗️ЕЩЕ БОЛЬШЕ СТАТЕЙ ОБ APPLE ИЩИТЕ В НАШЕМ ДЗЕНЕ СОВЕРШЕННО БЕСПЛАТНО

FastVLM — это Visual Language Model, то есть модель, которая умеет смотреть на изображение или видео и описывать всё, что там происходит. Причём делает это очень быстро: по заявлению Apple, до 85 раз быстрее, чем аналоги, и при этом в три раза компактнее. Никаких серверов — вся обработка идёт локально, прямо в вашем браузере. А если вы вдруг окажетесь без интернета, то модель всё равно будет работать.

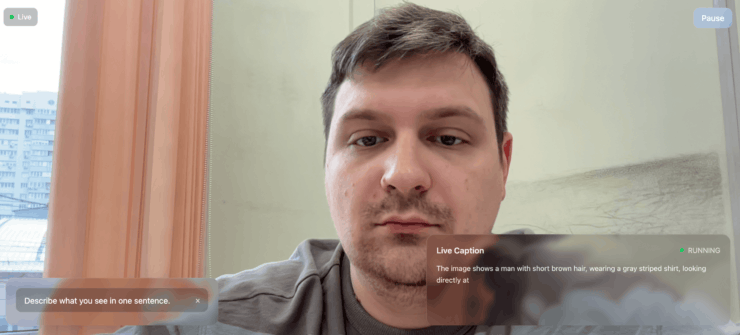

Работает это так: вы включаете камеру, и FastVLM начинает в реальном времени описывать, что она видит. Цвет вашей одежды, мимику, предметы в руках, даже текст на футболке или постере на стене — всё распознаётся и превращается в подписи. Можно выбрать один из готовых вопросов, вроде «Опиши, что ты видишь в одном предложении» или «Назови объект у меня в руке», а можно написать свой запрос.

Описание появляется на экране мгновенно

На практике всё выглядит впечатляюще: модель действительно цепляется за детали и подаёт их в коротких, точных фразах. Можно даже подключить виртуальную камеру и «кормить» FastVLM записью заранее снятых видео и наблюдать, как она пытается уследить за событиями на экране.

❗️ПОДПИСЫВАЙСЯ НА ТЕЛЕГРАМ-КАНАЛ СУНДУК АЛИБАБЫ, ЧТОБЫ ПОКУПАТЬ ТОЛЬКО ЛУЧШИЕ ТОВАРЫ С АЛИЭКСПРЕСС

Это, конечно, пока демонстрация. Но она отлично показывает, куда всё идёт. Локальная генерация описаний, полностью автономная, без отправки данных в облако. Идеальный сценарий для будущих носимых гаджетов или технологий доступности для людей с нарушениями зрения.

Можете добавить какой-нибудь предмет, и модель сразу же изменит описание

Сейчас на Hugging Face работает лёгкая версия модели — FastVLM-0.5B, у которой 0,5 миллиарда параметров. Есть и более тяжёлые варианты, до 7 миллиардов параметров, но в браузере они пока не потянут. Однако имейте в виду, что работает она пока исключительно на английском языке, что многие посчитают серьезным минусом.

Тем не менее даже базовая модель уже демонстрирует, на что способна Apple в области ИИ, и это очень интересно на фоне грядущих обновлений с Apple Intelligence. Попробовали FastVLM в деле? Напишите, насколько точно она описала вас.